时间:2018-01-10 16:06

人气:

作者:admin

深度学习的热潮还在不断涌动,神经网络再次成为业界人士特别关注的问题,AI 的未来大有可期,而深度学习正在影响我们的日常生活。近日斯坦福大学给我们分享咯一则他对深度神经网络可解释性的探索的论文,我们去看看他是如理解的吧!

近日,斯坦福大学计算机科学博士生 Mike Wu 发表博客介绍了他对深度神经网络可解释性的探索,主要提到了树正则化。其论文《Beyond Sparsity: Tree Regularization of Deep Models for Interpretability》已被 AAAI 2018 接收。

近年来,深度学习迅速成为业界、学界的重要工具。神经网络再次成为解决图像识别、语音识别、文本翻译以及其他困难问题的先进技术。去年十月,Deepmind 发布了 AlphaGo 的更强版本,从头开始训练即可打败最优秀的人类选手和机器人,表明 AI 的未来大有可期。在业界,Facebook、谷歌等公司将深度网络集成在计算 pipeline 中,从而依赖算法处理每天数十亿比特的数据。创业公司,如 Spring、Babylon Health 正在使用类似的方法来颠覆医疗领域。深度学习正在影响我们的日常生活。

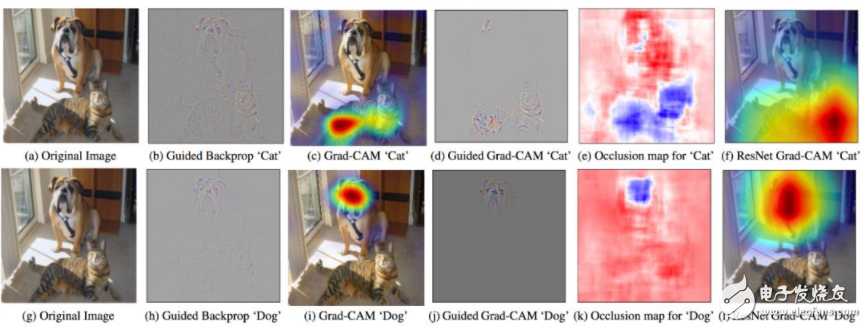

图 1:GradCam - 利用目标概念的梯度突出重要像素,从而创建决策的视觉解释。

但是深度学习是一个黑箱。我第一次听说它时,就对其工作原理非常费解。几年过去了,我仍然在探索合理的答案。尝试解释现代神经网络很难,但是至关重要。如果我们打算依赖深度学习制造新的 AI、处理敏感的用户数据,或者开药,那么我们必须理解这些模型的工作原理。

很幸运,学界人士也提出了很多对深度学习的理解。以下是几个近期论文示例:

Grad-Cam(Selvaraju et. al. 2017):使用最后卷积层的梯度生成热力图,突出显示输入图像中的重要像素用于分类。

LIME(Ribeiro et. al. 2016):使用稀疏线性模型(可轻松识别重要特征)逼近 DNN 的预测。

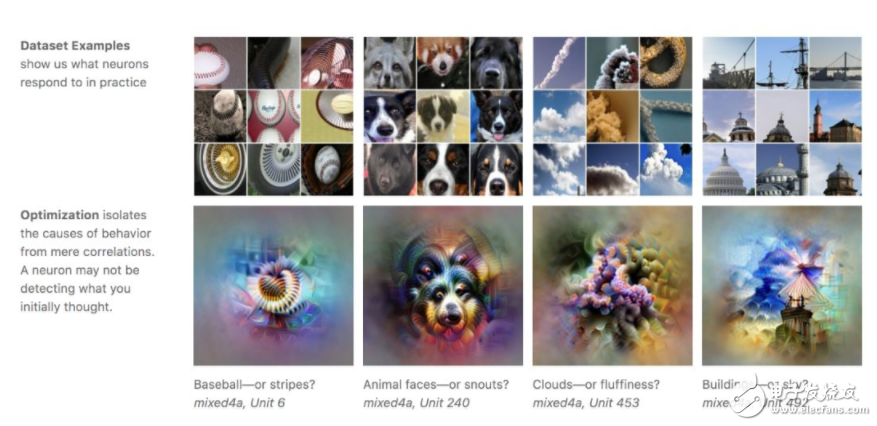

特征可视化(Olah 2017):对于带有随机噪声的图像,优化像素来激活训练的 DNN 中的特定神经元,进而可视化神经元学到的内容。

Loss Landscape(Li et. al. 2017):可视化 DNN 尝试最小化的非凸损失函数,查看架构/参数如何影响损失情况。

图 2:特征可视化:通过优化激活特定神经元或一组神经元,从而生成图像(Olah 2017)。

从上述示例中可见,学界对如何解释 DNN 存在不同见解。隔离单个神经元的影响?可视化损失情况?特征稀疏性?